如何将fishbot小车变为更加智能的小车,现在最想实现的是语音交互和指令执行,望大佬们指点指点思路和方向。

-

插眼,有时间也希望搞个智能机器人

-

@2438413171 哇塞,大佬我们又相见了,太兴奋了,又来我帖子了,先给大佬汇报下最近进展:

1、上次科大讯飞+键盘控制的方案最终放弃了;采用了新的方案,用vosk库替代了科大讯飞,用navigation2替代了键盘控制。

2、已用vosk库实现了语音识别,感觉与科大讯飞差不太多,也不是很准确。

3、然后使用espeakng库将文字合成语音播报。

4、利用API链接coze智能体将vosk识别的语音传过去,然后接收到反馈的内容已实现。

5、利用rviz2提前将目标点的坐标记录下来写入xml文件中,然后使用指令映射的方式写入navigation2的目标接收节点中,已实现导航。由于横跨太多内容,现在以上步骤都是单步单一功能实现的,接下来就是要把以上步骤完整的串起来,先完成既定导航目标的实现。现在唯一一个还没有确定的就是如何告诉navigation2初始位置。我在听小鱼老师的课时感觉这个还是有点难,所以这步先留着等我把上面单步实现的串联起来后再来解决这个问题。

再次感谢大佬上次的指点及本次的光顾,感谢!

也再次感谢小鱼老师免费的教学,随着学习的深入我才越来越体会小鱼老师的苦口婆心,不要复制粘贴代码不然看完视频没感觉,实际上根本没学进去。只有在自己继续深挖的过程中才会发现这些基础知识的重要性! -

@onedream 看了贴子有点遇到知音感觉,我也有此想法,我是想着后面语音控制小车能实现像现在电车那样在复杂路况上的模拟,除了语音转换感觉最难的是识别意图然后去执行对应的控制器;不知道能不能做到那种程度。越学习感觉学的东西还有很多,一起加油!

-

@jarvis 是的,思路上应该大差不差,我的终极目标也是将聊天和控制结合,就会走到你说的意识识别。这一步对我来说还是很遥远,不过现在技术发展很快,先把基础的打通,经验先积累着,说不定哪天就可以实现了啦!哈哈。

-

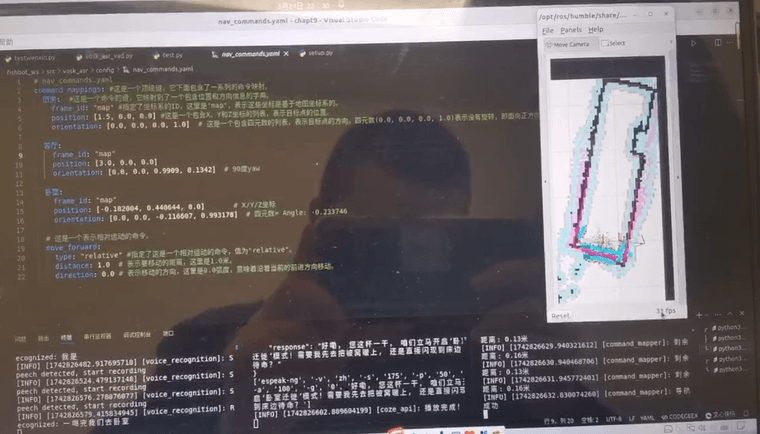

@onedream 经过一个多月的实践与学习,不停的改不停的改,总算是成功了。这期间做了以下优化:

1、将初始位置固定,并在启动nav2时自动实现初始位置。

2、成功将3个模块串联起来,vosk识别的语言通过发布者将内容传递给coze,然后收到coze消息后通过发布者传递给导航。美中不足的就是:

1、vosk识别非常不准确,而且每次都会不知道什么时候说话的结束。但是程序运行久了,我发现识别准确度会提高,这是什么情况啦?

2、为了实现以上功能我打开了5个终端同时运行,不知道能否实现一个终端实现以上流程。本想上传视频结果发现不能,那我就上传图片吧

-

@小鱼 对了,小鱼老师,我请教下,我想在fishbot小车上装上麦克风阵列用于接收语音消息。这个是随便在淘宝上买个就可以实现吗?还是要基于你开发的主控板来有针对性的选择麦克风阵列啦?还需要增加其他主控版吗?恳请有空时指导下,谢谢小鱼老师。

-

@onedream launch文件研究一下。把node启动都放到一个lanuch文件里就可以了。

-

@onedream 随便一个即可

-

@499391260 要的,谢谢大佬指点。

-

@小鱼 好的,谢谢小鱼老师。